Как извлечь все ссылки

- Как извлечь все ссылки с веб-страницы

- Использование программы Xenu's Link Sleuth

- Шаги для извлечения ссылок

- Создайте новый проект в программе Xenu's Link Sleuth.

- Установите параметры работы программы.

- Получите список страниц и ссылок сайта.

- Извлеките все ссылки отдельной страницы.

- Извлеките все ссылки сайта.

- Полезные советы

Как извлечь все ссылки с веб-страницы

Интернет живет ссылками. По ссылкам пользователи переходят между страницами сайтов. Путем публикации ссылок привлекается внимание к интересным ресурсам. Ссылки используются поисковыми системами для пополнения поисковой базы и расчета параметров, используемых при ранжировании. Ссылки - основа web. Именно поэтому правильная перелинковка и корректная ссылочная структура так важна для каждого ресурса. И именно поэтому каждый web-мастер должен знать ответ на вопрос о том, как извлечь все ссылки сайта, отдельной страницы или группы страниц.

Использование программы Xenu's Link Sleuth

Для извлечения всех ссылок с веб-страницы вам понадобится бесплатная программа Xenu's Link Sleuth. Вы можете скачать ее по адресу http://home.snafu.de/tilman/xenulink.html. Кроме того, вам потребуется подключение к интернету.

Шаги для извлечения ссылок

Создайте новый проект в программе Xenu's Link Sleuth.

В главном меню приложения выберите пункт "File", а затем "Check URL...", либо нажмите сочетание клавиш Ctrl+N. В отобразившемся диалоге "Xenu's starting point" в верхнем поле введите URL страницы, с которой нужно начать извлечение ссылок. При необходимости заполните поля в группе элементов управления "Include / Exclude" для внесения дополнительных внешних адресов и групп адресов в возможный список проверки и принудительного запрета некоторых адресов или групп адресов к индексации приложением.

Установите параметры работы программы.

В диалоге "Xenu's starting point" нажмите кнопку "More options...". Будет отображен диалог "Options". Переключитесь на вкладку "Basic" диалога. Путем движения ползунка "Parallel Threads" установите количество параллельных потоков, загружающих данные из интернета. В поле "Maximum depth" введите значение максимальной глубины просмотра ссылок приложением. В группе элементов "Report" активируйте или отключите опции формирования отчета. Переключитесь на вкладку "Advanced". Активируйте или отключите дополнительные опции. В поле "Retries" введите значение максимального количества повторных запросов URL при неудаче. Нажмите кнопку "OK".

Получите список страниц и ссылок сайта.

В диалоге "Xenu's starting point" нажмите кнопку "OK". Приложение начнет работу. В строке состояния будет отображаться информация о ходе процесса получения данных. Дождитесь завершения процесса. В окне с запросом на создание отчета (окно с текстом "Link sleuth finished. Do you want a report?") нажмите кнопку "Нет".

Извлеките все ссылки отдельной страницы.

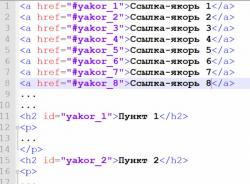

В построенном приложением списке страниц найдите ту, ссылки которой необходимо извлечь. Кликните правой кнопкой мыши по соответствующей строке. В контекстном меню выберите пункт "URL Properties". В поле "...links on this page" отобразившегося диалога будет содержаться список всех ссылок, присутствующих на странице. В поле "...linking to this one" будут приведены адреса страниц, ссылающихся на данную.

Извлеките все ссылки сайта.

В главном меню выберите пункт "File", а затем пункт "Export Page Map to TAB separated File...". В появившемся диалоге укажите имя и путь для сохранения файла. Полученный файл содержит все адреса ссылающихся и целевых страниц в полях OriginPage и LinkToPage. В поле LinkToPageStatus приведены значения успешности операции получения данных с сервера. Импортируйте файл в базу данных (например, MS Access) для извлечения ссылок в соответствии с нужными критериями.

Полезные советы

Использование большого количества параллельных потоков может вызвать серьезную нагрузку на сервер. При наличии ошибок загрузки информации выберите в меню пункты "File" и "Retry broken links" либо нажмите Ctrl+R для повторной проверки ошибочных URL.